数据爬虫在获取网络信息时扮演着关键角色,但随着网站反爬机制的强化,爬虫工作面临诸多挑战。本文将探讨四个常见的数据爬虫挑战,并提出基于代理代办技术的解决方案,同时提供简单的测试方法以验证其有效性。

挑战1:IP被封禁或限制访问

许多网站会监控请求频率,如果来自同一IP地址的请求过多,可能会暂时或永久封禁该IP,导致爬虫无法继续工作。

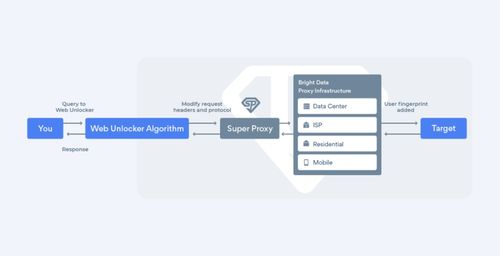

解决方案:使用代理IP池

通过代理代办服务,爬虫可以轮换使用多个IP地址,分散请求压力。代理IP池能够自动切换IP,降低被封风险。

测试方法:在爬虫脚本中集成代理服务,连续发送请求至目标网站(如电商平台),观察是否出现IP封禁提示。对比使用代理前后,成功率的变化。

挑战2:反爬虫机制(如验证码和JavaScript渲染)

现代网站常采用验证码、动态内容加载(通过JavaScript)等手段,阻止自动化爬取。

解决方案:结合代理与智能解析工具

代理代办可以隐藏真实IP,同时配合Headless浏览器(如Selenium或Puppeteer)模拟用户行为,处理JavaScript渲染。对于验证码,可集成OCR服务或人工打码平台。

测试方法:设置爬虫任务访问有验证码或动态内容的页面(如社交媒体网站),使用代理和解析工具后,检查是否能成功提取数据。记录成功率和响应时间。

挑战3:地理位置限制和访问频率控制

某些网站根据用户地理位置提供不同内容,或对高频访问实施严格限制。

解决方案:代理代办提供地理定位IP

代理服务可提供特定国家或地区的IP地址,绕过地理封锁。同时,通过代理轮换,可以模拟正常用户访问频率,避免触发频率限制。

测试方法:使用代理IP访问地理限制网站(如流媒体平台),验证是否能获取内容。同时,模拟高频请求,检查代理是否有效分散请求,避免被封。

挑战4:数据完整性和稳定性问题

爬虫过程中,网络波动或代理质量差可能导致数据丢失或请求超时,影响爬虫的稳定性。

解决方案:选择高可用代理服务并实施错误重试机制

代理代办提供商通常有服务等级协议(SLA),确保高可用性。爬虫代码应包含重试逻辑,当代理失败时自动切换IP或重试请求。

测试方法:在长时间运行爬虫任务时,监控数据获取的完整性和错误率。使用多个代理供应商进行对比测试,评估其稳定性和响应速度。

总结

代理代办技术是应对数据爬虫挑战的有效手段,通过IP轮换、地理定位和稳定性保障,显著提升爬虫效率。在实际应用中,建议选择可靠的代理服务商,并结合具体场景进行测试优化,以确保数据爬取的持续性和准确性。通过上述解决方案和测试,开发者可以更好地克服爬虫障碍,实现高效数据采集。